5 trendów, które mogą pomóc wyprzedzać zachodzące zmiany i zapewniać klientom coraz lepsze usługi – prezentuje Dave Russell, wiceprezes ds. strategii produktu w firmie Veeam.

- Wzrost wykorzystania środowisk wielochmurowych

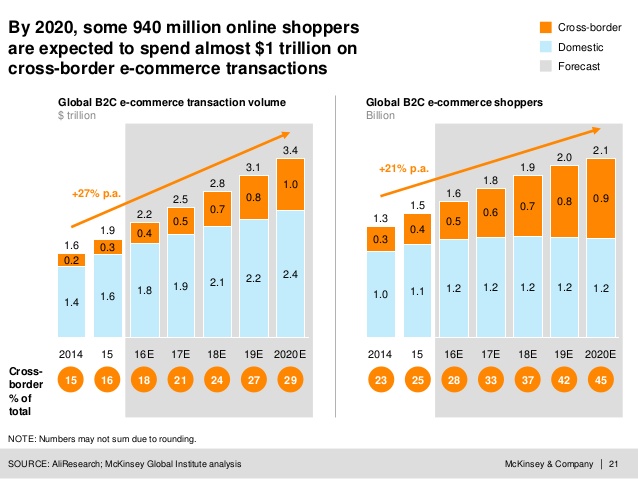

Już w 2016 w raporcie DIGITAL GLOBALIZATION: THE NEW ERA OF GLOBAL FLOWS firma McKinsey & Company wskazała, że od 2005 roku przepływ danych do Azji wzrósł co najmniej 45-krotnie.

Szybkość przesyłu danych z najważniejszych regionów, takich jak Ameryka Północna i Europa, wzrosła drastycznie, osiągając wartość (odpowiednio) 5000–20000 Gb/s oraz 1000–5000 Gb/s, podczas gdy w 2005 roku wynosiła ona zaledwie 100–500 Gb/s oraz mniej niż 50 Gb/s.

Wiele firm prowadzi działalność na skalę międzynarodową, a ich zależność od technologii staje się coraz bardziej wyraźna. To właśnie dlatego ekspansja w obszarze środowisk wielochmurowych wydaje się niemal nieunikniona. Jak szacuje firma IDC, w 2021 roku klienci wydadzą 554 miliardy dolarów na chmury obliczeniowe i związane z nimi usługi — to ponad dwukrotnie więcej niż w 2016 roku. Lokalne dane i aplikacje nie staną się zbędne, jednak modele wdrażania rozwiązań związanych z danymi będą ewoluować w kierunku połączenia systemów lokalnych, SaaS, IaaS oraz chmur zarządzanych i prywatnych.

Oczekuje się, że z czasem coraz większa liczba systemów będzie przenoszona poza środowiska lokalne. Mimo że ta transformacja będzie odbywać się na przestrzeni lat, naszym zdaniem ważne jest, abyśmy już dziś byli gotowi sprostać wymogom nowej rzeczywistości.

- W 2019 roku wzrośnie podaż pamięci flash, a jej ceny spadną

Wg Gartnera, w połowie 2019 podaż pamięci flash powróci do stanu nieznacznego niedoboru, po czym jej ceny się ustabilizują — głównie ze względu na wzrost produkcji w Chinach.

Większa podaż i korzystniejsze ceny spowodują szersze stosowanie pamięci flash w warstwie operacyjnej przywracania danych, obejmującej zazwyczaj kopie zapasowe i repliki danych z ostatnich czternastu dni. Większa pojemność pamięci flash doprowadzi także do szerszego wykorzystania możliwości szybkiego montowania kopii zapasowych obrazów maszyn (tzw. Copy Data Management — zarządzanie danymi kopii).

Systemy udostępniające funkcję Copy Data Management będą w stanie dostarczać wartość, która wykroczy poza samo zapewnianie dostępności i przełoży się na lepsze wyniki finansowe. Przykłady wykorzystania kopii zapasowych i replik danych możemy znaleźć w obszarach DevOps, DevSecOps i DevTest, a także testowania poprawek (Patch Testing), analizy i raportowania.

- Analiza predykcyjna trafi do głównego nurtu i stanie się wszechobecna

Przewiduje się, że do 2022 roku rynek analizy predykcyjnej osiągnie wartość 12,41 miliarda dolarów, co będzie oznaczać wzrost o 272% w stosunku do roku 2017, przy CAGR wynoszącym 22,1%. Najwyższą wartość CAGR w okresie objętym prognozą przewiduje się w regionie Azji i Pacyfiku.

Analiza predykcyjna oparta na danych telemetrycznych – zasadniczo na wytycznych i zaleceniach popartych uczeniem maszynowym (ML) – to jedna z technologii, które najprawdopodobniej wejdą do głównego nurtu i staną się wszechobecne.

Prognozowanie z użyciem uczenia maszynowego nie jest nowym rozwiązaniem, jednak już wkrótce technologia ta będzie przetwarzać podpisy i odciski palców oraz stosować zasady i konfiguracje oparte na najlepszych praktykach, umożliwiając firmom pozyskiwanie większej wartości z wdrożonej i utrzymywanej infrastruktury.

Diagnostyka predykcyjna pomoże nam zapewnić ciągłość działalności, zmniejszając jednocześnie skalę obciążeń administracyjnych związanych z zachowaniem optymalnego działania systemów. Możliwości te stają się niezwykle istotne, ponieważ działy informatyczne są zmuszone do zarządzania coraz bardziej zróżnicowanym środowiskiem — z coraz większą ilością danych i coraz bardziej rygorystycznymi celami w dziedzinie poziomu usług.

W miarę wzrostu popularności analizy predykcyjnej rosną również wymogi SLA i SLO, a oczekiwania firm związane z poziomem usług (SLE) stają się coraz wyższe. Taki stan rzeczy oznacza, że potrzebujemy większego wsparcia i wiedzy, aby realizować cele stawiane nam przez firmy.

- Nowy model panujący w większości działów informatycznych będzie stawiał na osoby zdolne do szybkiej adaptacji do nowych ról

Podczas gdy pierwsze dwa trendy skupiają się wokół technologii, w przyszłości cyfrowego świata wciąż obecny będzie czynnik „analogowy”, czyli ludzie. Niedobory talentów, w połączeniu z szybko zmieniającą się infrastrukturą oraz stosowaniem chmur publicznych i SaaS, stwarzają wymóg korzystania z techników o szerszym portfelu umiejętności, dysponujących doświadczeniem w wielu różnych dziedzinach, a także coraz większą świadomością biznesową. Wysoki poziom rekrutacji na rynku informatycznym obserwujemy dziś np. w Singapurze.

Co więcej, standaryzacja, orkiestracja i automatyzacja przyczyniają się do przyspieszenia tego procesu: wydajniejsze systemy pozwalają bowiem administratorom zyskać szersze spojrzenie — zamiast skupiać się na wąskiej specjalizacji. Rzecz jasna, specjalizacja wciąż będzie ważna, jednak w miarę wzrostu wpływu informatyki na wyniki biznesowe konieczny będzie rozwój talentów informatycznych w wielu różnych domenach.

Powyższe tendencje z pewnością wpłyną na sytuację w przyszłym roku, jednak pewne rzeczy pozostaną niezmienione. Zawsze istnieją bowiem pewne stałe elementy, a dwa z nich będą nadal niezwykle ważne dla firm na całym świecie.

- Przestarzałe rozwiązania i podejścia do tworzenia kopii zapasowych będą powodem do frustracji

W 2019 roku trzech największych dostawców będzie nadal tracić udziały w rynku. Co więcej, największy dostawca obecny na rynku traci swoją pozycję już od 10 lat. Firmy odchodzą od dotychczasowych dostawców i kierują wzrok ku nowym — bardziej prężnym, dynamicznym i rewolucyjnym, takim jak Veeam, aby zyskać możliwości potrzebne do rozwoju w erze wszechobecnej cyfryzacji.

- Nadal utrzymają się trzy ważne problemy: koszty, złożoność i niewystarczające możliwości

Te trzy wyzwania wciąż stanowią powody, dla których osoby pracujące w centrach przetwarzania danych są niezadowolone z rozwiązań innych dostawców. Nadmierne koszty, zbędna złożoność i braki w możliwościach przejawiają się w takich aspektach jak szybkość tworzenia kopii zapasowych bądź też czas przywracania danych lub montowania obrazów maszyn wirtualnych. Te trzy problemy nadal będą głównymi przyczynami rozszerzenia lub całkowitej wymiany rozwiązań do tworzenia kopii zapasowych w przedsiębiorstwach.

- Pojawienie się pierwszych sieci 5G otworzy przed dilerami i dostawcami usług przetwarzania w chmurze nowe możliwości gromadzenia, przechowywania i przetwarzania coraz większych ilości danych.

Na początku 2019 roku będziemy świadkami wejścia na rynek pierwszych telefonów z obsługą sieci 5G. Stanie się to na targach CES w Stanach Zjednoczonych oraz MWC w Barcelonie. Moim zdaniem technologia 5G zostanie najszybciej zaadoptowana przez rozwiązania komunikacji między maszynami oraz przez technologię Internetu rzeczy (IoT). Obecnie stosowane sieci 4G osiągnęły bowiem punkt, w którym szybkość przesyłu danych jest obecnie wystarczająca dla większości osób korzystających z sieci mobilnych.

W 2019 r. więcej uwagi poświęci się pełnej standaryzacji i testowaniu technologii, a także przygotowywaniu urządzeń na przyszłe potrzeby — tak, aby mogły współpracować z nową technologią, gdy stanie się ona szerzej dostępna, a Europa stanie się prawdziwie gigabitowym społeczeństwem.

Sprzedawcy i dostawcy usług przetwarzania w chmurze z pewnością zwrócą uwagę na rozwój nowych możliwości generowania przychodów, które będą wykorzystywać infrastrukturę lub sieci 5G. Przetwarzanie większych ilości danych w czasie rzeczywistym i z większą szybkością, nowe wymogi związane ze sprzętem i urządzeniami oraz nowe aplikacje do zarządzania danymi otworzą liczne nowe możliwości oraz ułatwią prowadzenie rozmów na temat przetwarzania danych na krawędzi sieci.

Autor: Dave Russell, wiceprezes ds. strategii produktu w firmie Veeam

DIGITAL GLOBALIZATION: THE NEW ERA OF GLOBAL FLOWS firma McKinsey & Company