W 2019 w sieci pojawiło się dwa razy więcej filmów wykorzystujących technologię deepfake niż jeszcze rok wcześniej. Są też przykłady na to, że technologia ta może służyć do cyberkradzieży.

Wyobraźmy sobie, że w firmie dzwoni telefon. W słuchawce słyszymy głos kontrahenta, proszący o zmianę numeru konta do przelewu. Bez namysłu spełniamy jego prośbę… i narażamy się na wielotysięczne straty. Głos nie należał bowiem do prawdziwego rozmówcy, ale był jego cyfrowym odwzorowaniem, stworzonym przez hakera na bazie zaledwie minutowej próbki oryginału. Brzmi jak scenariusz nowego odcinka Black Mirror? Nic bardziej mylnego! To tylko deepfake.

Deepfake głębiej…

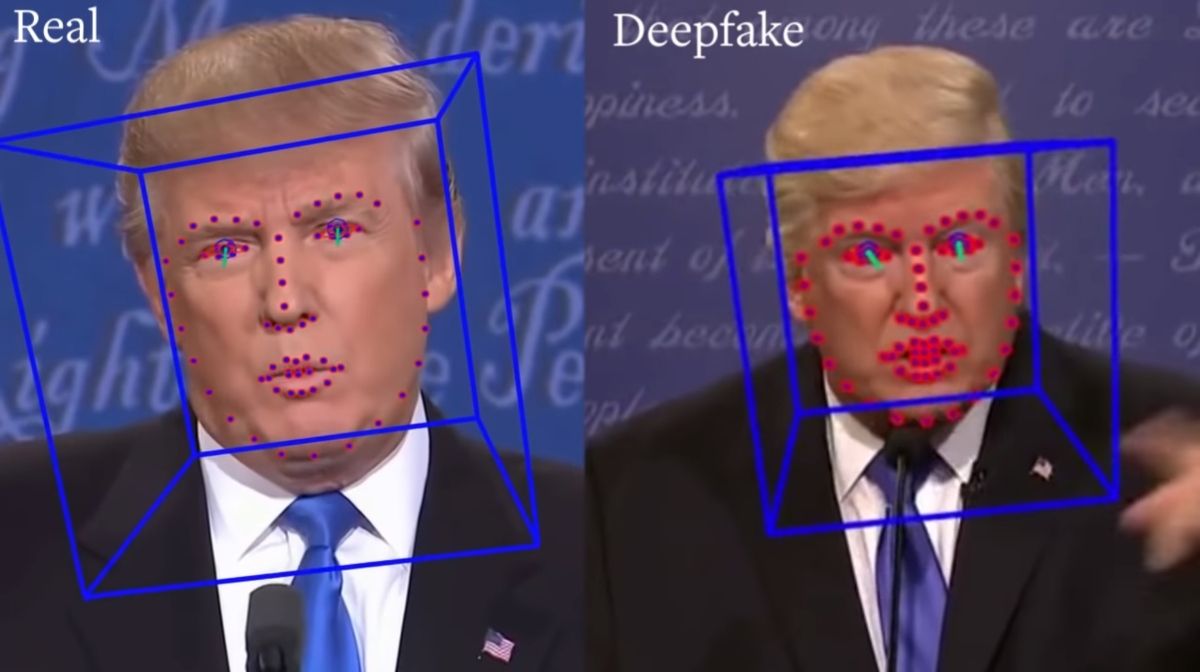

Deepfake to technologia, która zastosowana wraz z cyfrową modulacją głosu pozwala na generowanie realistycznych, łudząco podobnych do oryginału postaci. – Najnowocześniejsze algorytmy sztucznej inteligencji (AI) potrzebują zaledwie jednego zdjęcia i jedynie 5-sekundowej próbki głosu, aby móc wygenerować niemalże identyczny hologram deepfake, którego odróżnienie od pierwowzoru, bez użycia specjalistycznych metod, jest praktycznie niemożliwe – tłumaczy Wojciech Lika z TestArmy CyberForces, firmy specjalizującej się w systemach bezpieczeństwa IT.

Pierwsze algorytmy deepfake pojawiły się z końcem 2017 roku, a wykorzystywane były głównie w branży pornograficznej. Do ciała aktora dodawano wygenerowaną cyfrowo twarz celebryty, w efekcie czego otrzymywaliśmy scenę filmową z postacią łudząco przypominającą hollywoodzki pierwowzór. Dziś problem sięga dużo głębiej, a skuteczna walka z deepfake jest trudniejsza niż kiedykolwiek. O tym, że zasięg deepfake rośnie, mówią liczby:

- Jeszcze w 2018 roku w internecie można było znaleźć 7964 filmy wykorzystujące technologię deepfake. Dziś liczba ta urosła blisko dwukrotnie, do 14 698, jak pokazują badania Deeptrace opublikowane w grudniu 2019 roku.

- Już 12 proc. filmów deepfake (z odsetka tych o niepornograficznym charakterze) uderza w polityków, 5 proc. – w dziennikarzy, a 2 proc. w osoby z kręgów biznesowych.

- Obecnie istnieje 20 niezależnych portali internetowych odpowiedzialnych za wytwarzanie deepfake (tzw. deepfake creations).

- Do tej pory treści deepfake stworzyło 96 tys. unikalnych użytkowników zarejestrowanych na forach i witrynach deepfake creations.

Sztuczna inteligencja to przyszłość technologii, jednak, gdy znajdzie się w nieodpowiednich rękach, może stanowić poważne zagrożenie. Zjawisko deepfake jest tego doskonałym przykładem, bo przy użyciu algorytmów sztucznej inteligencji z powodzeniem można manipulować wyodrębnionymi grupami, dyskredytować poszczególne osoby czy nawet decydować o przebiegu wyborów lub powstawaniu konfliktów zbrojnych o skali globalnej. Potwierdzają to przykłady z życia wzięte:

- Belgia: Flamandzka Partia Socjalistyczna nakręciła fałszywe wideo z przemówieniem Donalda Trumpa, w którym prezydent USA wzywa kraj do pójścia w ślady Ameryki i wyjścia z porozumienia klimatycznego z Paryża: „Jak wiecie, miałem jaja do wycofania się z porozumienia klimatycznego z Paryża. To, co teraz robicie w Belgii, jest w rzeczywistości gorsze. Zgodziliście się, ale nie podejmujecie żadnych działań. Tylko blablabla bingbangboom” – mówi fałszywy prezydent, pod koniec dodając: „Wszyscy wiemy, że zmiany klimatu są fałszywe, tak jak ten film”. W ten sposób partia rozpoczęła debatę publiczną, aby zwrócić uwagę na konieczność działania w sprawie zmian klimatu. Na końcu wideo wezwała do podpisania petycji zachęcającej do inwestowania w energię odnawialną, samochody elektryczne i transport publiczny. Wezwała również do zamknięcia elektrowni jądrowej Doel we Flandrii.

- Gabon: noworoczne przemówienie prezydenta Ali Bongo zostało oznaczone przez opozycję jako deepfake. Chociaż nie udowodniono, że wideo zostało sfałszowane, miało ono potężne implikacje wywołując (nieudany) zamach wojskowy.

Ale deepfake dotyczy nie tylko polityków czy celebrytów. Są przykłady na to, że to potężna broń w rękach cyberprzestępców, skierowana w stronę dochodowych firm i wpływowych przedsiębiorców:

- Nie tak dawno Wallstreet Journal poinformował o oszustwie dokonanym metodą deepfake przy użyciu cyfrowej modulacji głosu, gdzie przestępca podszywający się pod prezesa brytyjskiej firmy energetycznej, zlecił wykonanie przelewu o równowartości ok. 1 mln PLN. Jak tłumaczył wówczas Rüdiger Kirsch, fraud expert z firmy gwarancyjnej Euler Hermes, która pokryła straty: “efekt oszustwa był tak dobry, że brytyjski pracownik rozpoznał nawet jego lekko niemiecki akcent”.

Czy można obronić się przed deepfake?

– Elementem decydującym o bezpieczeństwie podczas korzystania z technologii jest świadomość zagrożeń, jakie może za sobą nieść. Im więcej wiemy na temat wykorzystywanych rozwiązań, im więcej scenariuszy potencjalnych wydarzeń znamy, tym skuteczniej i racjonalniej możemy przeciwdziałać wszelkim niebezpieczeństwom związanym z rozwojem nowoczesnych technologii – tłumaczy Wojciech Lika.

Ekspert alarmuje, że podstawową bronią w walce z deepfake jest edukacja pracowników i osób decyzyjnych ze środowiska biznesowego. Kluczowe są testy socjotechniczne, w ramach których dokonuje się kontrolowanych ataków hakerskich. Dzięki nim firmy mogą poznać, a docelowo także eliminować luki w swoich systemach bezpieczeństwa. Dzięki rosnącej świadomości współpracowników, poprzez pokazanie na żywym organizmie, jak działają cyberprzestępcy, można znacznie ograniczać ryzyko popełnienia błędu ludzkiego podczas bezpośredniego spotkania z hakerem.

Edukacja jest tym ważniejsza, że nie opracowano jeszcze w pełni skutecznych narzędzi do wykrywania algorytmów deepfake. Wśród środków zaradczych, po które można sięgnąć, są takie technologie, jak np. Sherlock AI, który pozwala na wykrycie anomalii w filmach wideo, Blockchain, który ma chronić rejestry danych przed manipulacjami czy Natural Hash, który umożliwia twórcom treści na osadzanie w materiałach źródłowych nieedytowalnych cyfrowych znaków wodnych.

Źródło: TestArmy CyberForces